SWRC) Matrix Factorization Models for Knowledge Base Population 논문 요약

<Matrix Factorization Models for Knowledge Base Population.>

Abstract

- 지식베이스의 목표는 모든 지식을 데이터베이스화, but 지식 획득 능력 부족.

- 지식획득은 주로 웹 상에 있는 자연언어문장을 지식화하는 외부 지식 획득을 통해 이루어지나, 지식베이스 내부에서 지식 확장을 하는 방법에서는 연구가 소홀함.

- 본 연구에서는 지식베이스를 행렬화하여 행렬 분해 모델을 통해 새로운 지식에 대해 신뢰성을 확인.

Introduction

- 방대한 지식을 효율적으로 저장 : 트리플 형태 <주어, 관계, 목적어>

- 유용히 지식베이스를 쓰는 조건

- 포함하는 정보의 범위가 넓어야 함. 포함하고 있는 정보의 정확성이 높아야 함.

- 기존 지식베이스에 지식을 추가하기 위한 지식베이스의 확장 필요성 대두.

- 지식획득은 interior knowledge acquisition, exterior knowledge acquisition으로 나눌 수 있음. 보통 웹에 존재하는 NL 문장을 읽고 지식을 추출하는 관계 추출에 연구가 집중되어 있음. => 보통, 영어 도메인에서 자연언어문장을 읽어 들여 개체간 관계를 나타내는 트리플을 추출하는 문제, 허나 지식베이스 사용의 효율성을 위해서는 내부적인 지식 획득 동반의 필요성. => 기존에는 벡터 분해 모델을 이용한 연구가 없다.

KBMF (Knowledge Base Matrix Factorization)

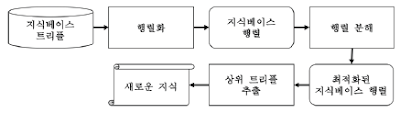

- 행렬화 단계, 행렬 분해 단계, 상위 트리플 추출 단계로 이루어짐

- 지식베이스 트리플 -> 행렬화 -> 지식베이스 행렬 -> 행렬 분해 -> Optimized 지식베이스 행렬 -> 상위 트리플 추출 -> 새로운 지식

- 지식베이스 행렬화: <주어, 목적어>로 이루어진 개체쌍을 행으로, 관계를 열로 가지는 행렬.

- 행렬 분해: 지식베이스 행렬화에서 얻은 행렬 K의 근사 행렬 K`을 구하는 것이 목표.

- 목적 함수: 어떤 개체쌍 t=<sbj, obj>가 관계 r_i을 관계 r_j보다 선호할 확률

- p(r_i >_t r_j│θ)≔σ((x_tij ) ̂(θ)), σ는 sigmoid function, θ는 모델의 자연 매개 변수, (x_tij ) ̂(θ)는 결과값이 실수인 함수이며, MF model에 따라 달라짐, 우리의 목적은 training data에 속한 (t, r_i)와 속해 있지 않는(t, r_j)에 대해 p(r_i >_t r_j│θ)를 최대화 하는 것.

- (x_tij ) ̂≔(x_ti ) ̂-(x_tj ) ̂,obj= ∑_((t,i,j)∈D)▒ln〖σ(〗 (x_tij ) ̂)-〖λ_θ ‖θ‖〗^2 : 학습데이터에 부여하는 확률 값과 나머지 데이터에 부여하는 확률 값, D≔{ (t,i,j)┤| (t,r_i )∈KB,(t,r_j )∉KB }

- 자연 매개 변수

(x_ti ) ̂가 의미하는 것은 최적화된 지식베이스 행렬의 slot 값

- f-model (latent feature model): 개체 쌍의 벡터 w와 특성벡터 h의 선형 결합으로 (x_ti ) ̂ 정의

- n-model (neighborhood model): 관계 간의 weight matrix R을 정의한 후, 어떤 트리플 (t, i)에 대해(t,r_j )∈KB를 만족하는 관계 j를 찾고 i와 j사이의 가중치 값 r_(i,j)의 합으로(x_ti ) ̂ 정의

- nf – model: n-model + f-model

- e-model (entity model): t=(e_1,e_2)에 대하여 각 개체별 특성e_1, e_2 정의하고, 이를 관계 벡터d_1, d_2와의 선형 결합. 관계벡터들은 각각 주어, 목적어 개체 특성 벡터를 의미

- nfe-model: 위의 모든 model을 결합.

- 행렬 분해 알고리즘 : 경사하강법 진행 (자연 매개 변수에 의한)

실험 결과

- 성능 평가 : AUC로 진행

- AUC= 1/|T| ∑_t▒〖1/|E(t)| ∑_((i,j)∈E(t))▒δ((x_ti ) ̂>(x_tj ) ̂ ) 〗, E(t)≔{(i,j)┤|(t,i)∈S_test⋀(t,j)∉(S_test⋃S_train)}

- nfe-model AUC value: 0.9530으로 가장 좋은 퍼포먼스

- 추출한 지식의 정밀도 평가

- Total_precision: 57%

- 관계의 종류에 따라 정밀도가 큰 차이로 변화함

- 개체쌍을 구성하는 학습데이터에 따라 정밀도가 크게 변하는데, 예를 들어 개체쌍에서 대부분 4개의 관계를 가진다할 때, 하나의 관계가 누락되는 경우, 학습데이터에서 나머지 3개의 관계와는 대부분 다른 값을 가지기 때문. 그러나 대부분 4개의 관계를 가진 학습데이터이기에, 그러한 양상을 띠게 되고 낮은 precision을 띠게 됨.

댓글

댓글 쓰기